13ème Édition de l'École d'Été en Traitement du Signal et des Images

Le thème 2018

Crédit : Dmitry - stock.adobe.com

L'édition 2018 qui a eu lieu du 01 au 07 juillet 2018 avait pour thématique principale :

Signaux, images et science des données

Résumé

A la confluence du traitement du signal et de l’apprentissage, l’objectif en est de faire le point sur des techniques d’analyse de données à grande échelle telles que le traitement de signal sur graphe, les réseaux de neurones, et la géométrie de l’information.

Informations

L'essentiel

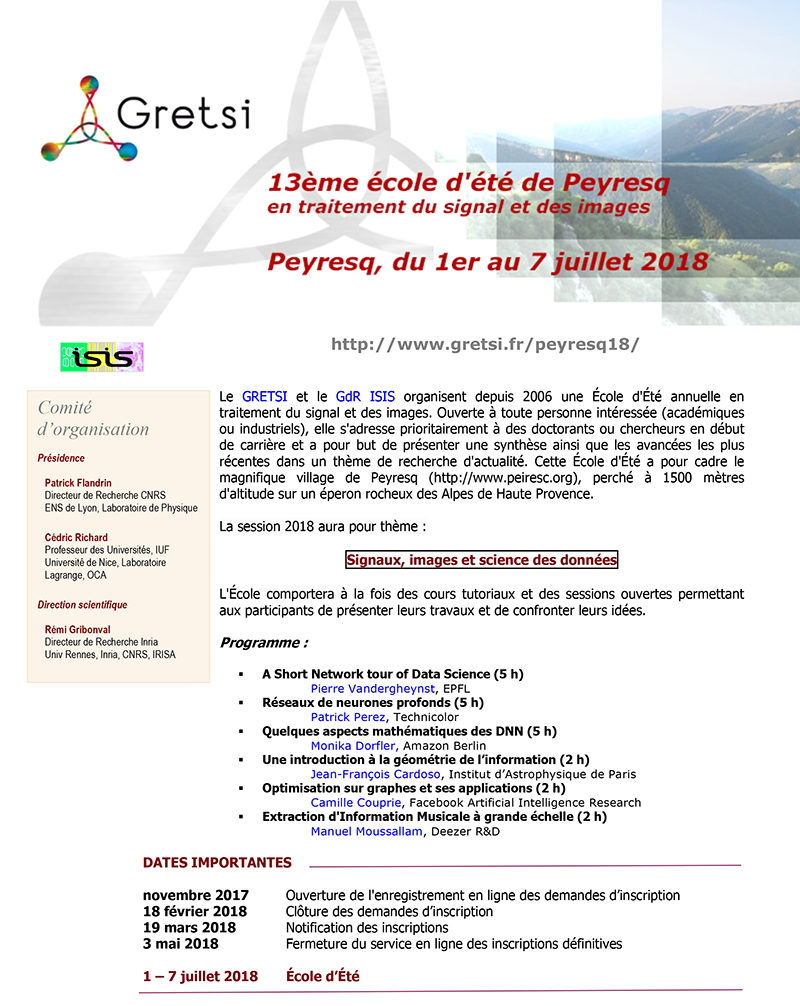

L'affiche

Le comité d'organisation

Présidence

- Patrick Flandrin, Directeur de recherche CNRS, Laboratoire de Physique, ENS de Lyon

- Cédric Richard, Professeur des Universités, Laboratoire Lagrange, Université de Nice.

Direction scientifique

- Remi Gribonval, Directeur de Recherche Inria, Univ Rennes, Inria, CNRS, IRISA, Rennes

Le programme détaillé

- A Short Network tour of Data Science (5 h)

Pierre Vandergheynst, Full Professor, EPFLMots clés : data science, graphs, networks, machine learning, signal processing on graphs,

This short course will cover an introduction to graph-based methods in data science. We will mostly focus on graph-based models and graph-based data processing methods, covering unsupervised and (semi)-supervised learning, graph learning, signal processing on graphs and neural networks for graph-based data.

- Réseaux de neurones profonds (5 h)

Patrick Perez, Scientific Director, Valeo.aiMots clés : apprentissage profond, neurones artificiels, réseaux convolutifs, réseaux récurrents, apprentissage de représentation, modèles génératifs,

Plan:

- Introduction : apprentissage machine et apprentissage profond

- Réseaux de neurones séquentiels : structure et apprentissage supervisé par rétropropagation du gradient

- Régularisation : a priori, augmentation de données, drop-out, etc.

- Réseaux convolutifs : filtres et tenseurs, agrégation, architectures, applications

- Réseaux récurrents : principes, architectures, apprentissage, applications

- Apprentissage de représentation : auto-encoders, auto-supervision, plongements contextuels

- Modèles génératifs : machine de Boltzman, auto-encodeur variationel, réseaux génératifs adversaires.

- Quelques aspects mathématiques des DNN (5 h)

Monika Dorfler, Researcher, Department of Mathematics, University of ViennaMots clés: Signal representations and feature extraction; approximation power of deep neural networks; regularization and generalisation in convolutional neural networks; equivalence of networks architectures.

Deep Learning has led to tremendous successes over the past decade. While the development of algorithms and the optimization of architectures from an empirical point of view has advanced in a breath-taking speed, theoretical explanations and a mathematical description of the setting of deep and convolutional neural networks lag behind. In this course, we will try to give an overview of the most important developments in the efforts to obtain satisfying theoretical explanations for the successes of deep learning. In particular, we will firstly give an introduction to the mathematical theory of an architecture’s expressiveness, which may be seen as an approximation theoretical description of neural networks. Secondly, we will try to understand the interaction of feature design, based on methods from Fourier analysis, and machine learning techniques in particular for audio signal.

- Une introduction à la géométrie de l’information (2 h)

Jean-François Cardoso, Directeur de recherche, Institut d’Astrophysique de ParisLes concepts et opérations de l'inférence statistique peuvent être exprimés dans un cadre géométrique. En géométrie de l’information, les points sont des distributions de probabilité et les surfaces sont des familles de distributions. Sur ces surfaces, c'est l’information de Fisher qui permet de définir la distance entre deux distributions voisines et qui définit (tout ou partie de) la géométrie intrinsèque d'un modèle statistique. Dans ce cours introductif, qui ne requiert pas de connaissance en géométrie différentielle, je montrerai comment on peut visualiser (ou géométriser) plusieurs notions élémentaires de statistique (modèles paramétriques, maximum de vraisemblance, estimation efficace, information de Fisher, familles exponentielles, statistiques exhaustives, maximum d'entropie...) s'interprètent naturellement comme des constructions géométriques où la divergence de Kullback joue un rôle central. Le but du cours est donc de donner à l'étudiant.e un éclairage géométrique à quelques problèmes et notions d'inférence qui, on l'espère, permettra de soutenir son intuition dans des travaux de traitement statistique du signal.

- Optimisation sur graphes et ses applications (2 h)

Camille Couprie, Research Scientist, Facebook Artificial Intelligence Research-

Optimisation variationnelle dans des graphes

- Découverte de 4 algorithmes de segmentation avec marqueurs dans les graphes (Min cut / max flow, Marcheur aléatoire, Plus courts chemins, Forets de poids maximum).

- Présentation d'un cadre unificateur de ces problemes et de la Ligne de partage des eaux puissance, nouvelle approche dans laquelle on fait tendre la puissance des poids du graphe vers l'infini, menant a d'interessantes propriétés.

- Applications des algos classiques et de la LPE puissance : segmentation sans marqueurs, sémantique, reconstruction de surface, stéréovision

- Applications en biologie: Integration d'a-priori biologiques dans la construction de réseaux de gènes.

- Génération d'images avec entrainement de réseaux adversaires

- Prédiction de trames futures dans des videos

- Génération d'images créatives

-

Optimisation variationnelle dans des graphes

- Extraction d'Information Musicale à grande échelle (2 h)

Manuel Moussallam, Head of Research, Deezer R&DMots clés : Apprentissage automatique sur la musique, traitement du signal audio, apprentissage multi-modal, passage à l’échelle.

Deezer gère un catalogue musical de plusieurs dizaines de millions de titres, et en reçoit quotidiennement des dizaines de milliers supplémentaires. Dans ce contexte, la curation manuelle aurait un coût prohibitif et le recours à l'analyse automatique des signaux et données pour extraire l'information est nécessaire. Nous présenterons les approches classiques en MIR, les évolutions du domaine liées aux progrès en apprentissage automatique et présenterons des travaux de recherche originaux menés au sein de la R&D.